GenAI Stack

GenAI Stack 是 Docker、Neo4j、LangChain 和 Ollama 之间的一项合作,在 DockerCon 2023 上发布。

安装

在 macOS 上,您必须先安装并启动 Ollama,然后才能使用 GenAI Stack。

git clone https://github.com/docker/genai-stack

cd genai-stack

# optionally copy env.example to .env and add your OpenAI/Bedrock/Neo4j credentials for remote models

docker compose up功能包括

-

带有本地或远程 LLM、Neo4j 和 LangChain 演示应用程序的 Docker 设置

-

根据需要拉取 Ollama 模型和句子转换器

-

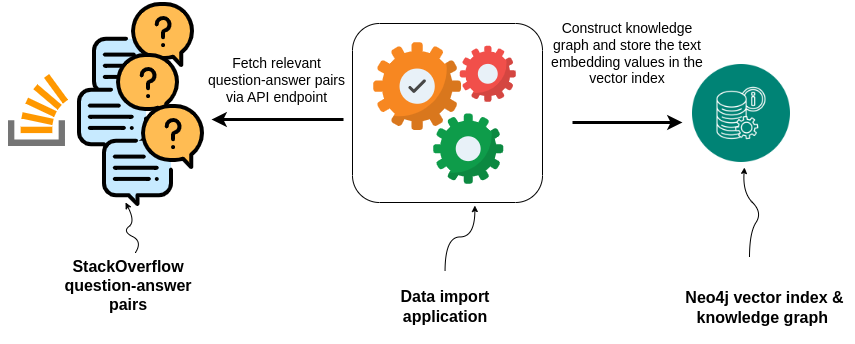

导入特定标签(例如

langchain)的 Stack Overflow 问题和答案 -

为问题和答案创建知识图谱和向量嵌入

-

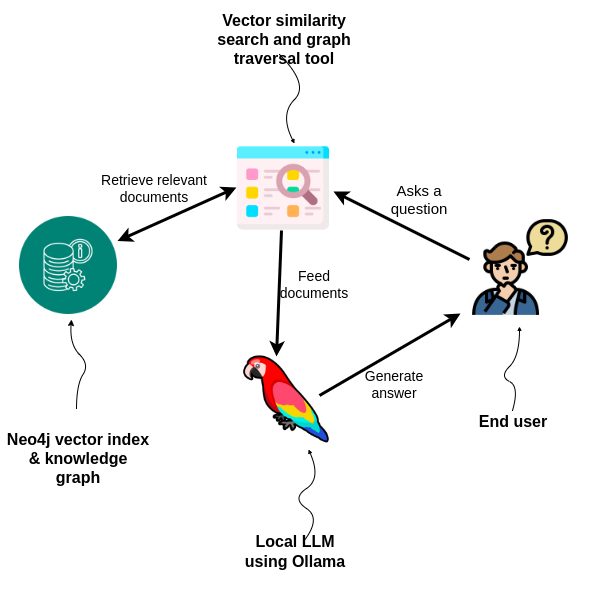

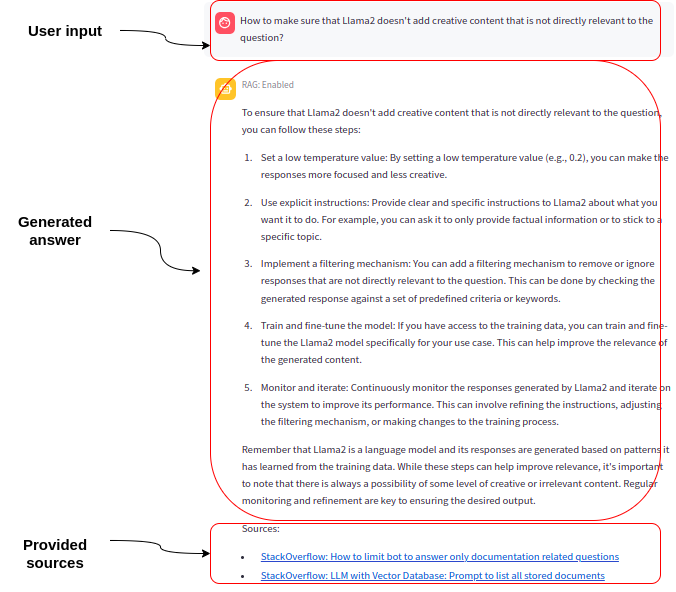

带有向量搜索和 GraphRAG(向量 + 图)答案生成的 Streamlit 聊天应用程序

-

为未回答的问题创建“支持工单”,同时考虑 Stack Overflow 上的优秀问题和实际问题

-

PDF 聊天,支持加载 PDF、分块、向量索引和搜索以生成答案

-

带有向量搜索和 GraphRAG(向量 + 图)答案生成的 Python 后端和 Svelte 前端聊天应用程序

文档

GenAI Stack 的详细演练可在 https://neo4j.ac.cn/developer-blog/genai-app-how-to-build/ 处找到。